Sie wollen eine klare Antwort: Ja, GPUs in einem Dual-Node-Gehäuse sind nicht nur machbar, sie sind praktisch. Zwei Hot-Swap-Knoten in einem Gehäuse bieten Ihnen Dichte, gemeinsame Stromversorgung und Lüfter sowie einfachere Betriebsabläufe. Der Trick besteht darin, das richtige Gehäuse, den richtigen Kühlpfad und das richtige E/A-Layout auszuwählen und dann die SKUs zu sperren, damit sich bei der Erstellung nichts "mysteriöserweise" ändert. Im Folgenden gehe ich auf die wirklichen Einschränkungen und die Vorteile ein, in einfachen Worten, mit Tabellen und konkreten Schlussfolgerungen. Ich werde auch zeigen, wo IStoneCase passt, wenn Sie OEM/ODM oder Massenware benötigen.

GPU-Doppelknoten-Gehäuse (2U/4U mit Multi-GPU)

A Doppelknoten-Gehäuse ist eine Box mit zwei unabhängigen Rechenschlitten. Jeder Knoten verfügt über eine eigene CPU, Speicher, Storage und PCIe-Lanes. Das Gehäuse teilt sich die Netzteile und die Lüfterwand. Mit dem richtigen Luftstrom und der richtigen Lane-Zuordnung kann jeder Knoten mehrere GPUs ansteuern - oft drei doppelt breite oder mehr einfach breite, je nach Steckplatzgeometrie und Thermik.

Wenn Sie auf der Suche nach einem server rack pc gehäuse, Server-PC-Gehäuse, oder Computergehäuse Server die zwei Knoten plus Beschleuniger beherbergen können, sollten Sie zunächst die TDP des Grafikprozessors mit der Lüfter- und PSU-Auslastung abgleichen. Raten Sie nicht, sondern lesen Sie die Lüfterkurve und die Spezifikationen des Netzteils und lassen Sie dann Spielraum.

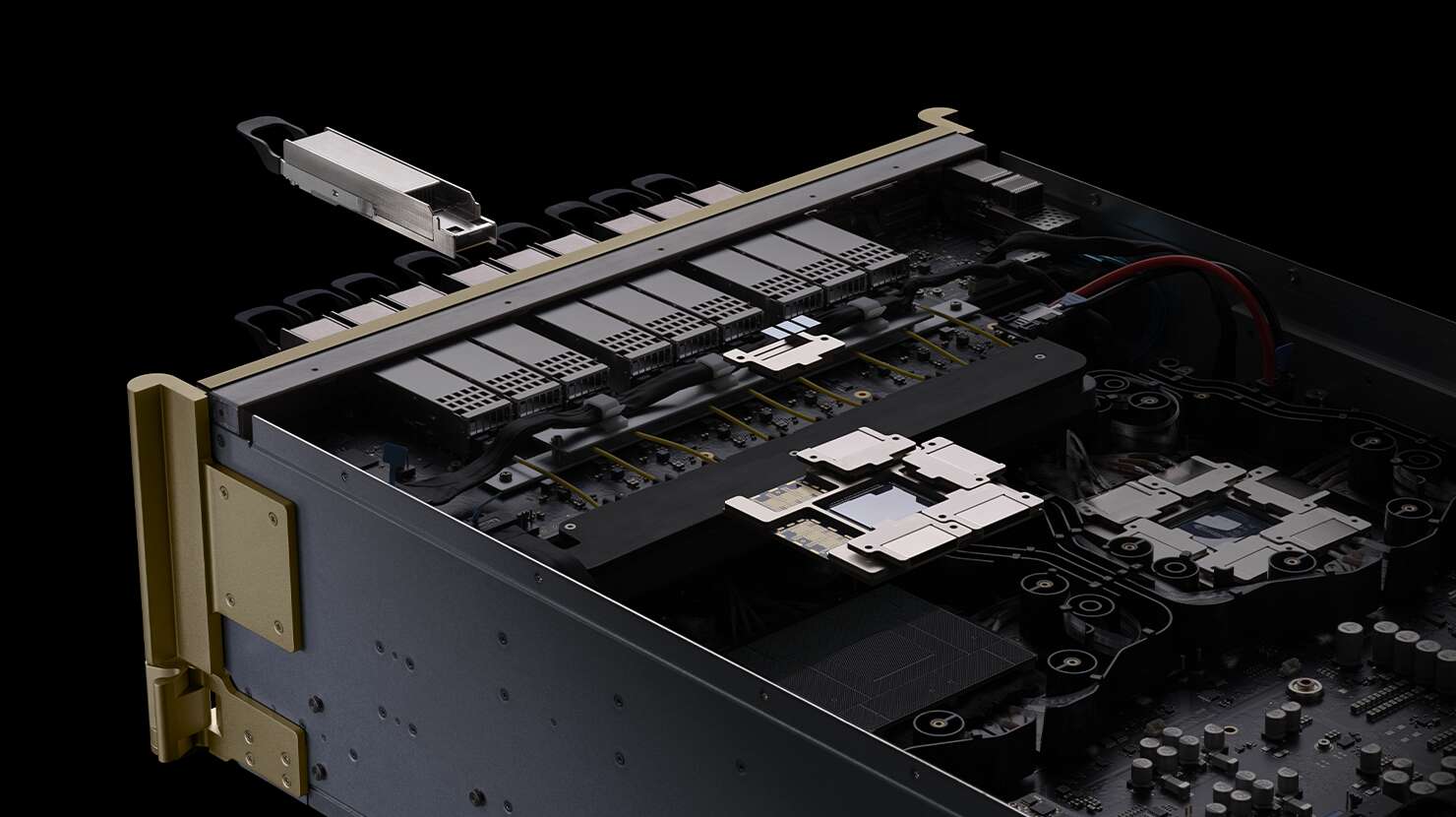

PCIe 4.0 x16 Lanes und OCP 3.0 NICs (Bandbreite und Topologie)

GPUs lieben Fahrspuren. Anstreben PCIe 4.0 x16 pro Beschleuniger (oder PCIe 5.0, sofern verfügbar). Verwenden Sie OCP 3.0 NIC (AIOM) für 100G+ Uplinks, ohne zusätzliche Steckplätze zu benötigen. Achten Sie auf PCIe-Bifurkation Regeln vom Anbieter der Karte. Wenn Sie benötigen GPUDirect-ish Muster über Knoten hinweg (z. B. Training von Sharded-Modellen oder schwere All-to-All-Inferenz), planen Sie die Struktur so In-Gehäuse-GPU-zu-GPU und knotenübergreifend Verkehr haben beide Platz. Nichts schmerzt mehr als eine glänzende GPU-Farm, die durch eine einzige NIC in die Enge getrieben wird.

Energie- und Kühlungsumschlag in 2U/4U-Dual-Node-Servern

Hier wird erfolgreich gebaut - oder überhitzt. Bestätigen Sie:

- PSU Headroom mit eingeschalteter Redundanz; vermeiden Sie das Laufen in der Nähe der Schienen.

- Luftstrom von vorne nach hinten ausgerichtet auf Ihren Warm-/Kaltgang. Füllen Sie die leeren Platten; lassen Sie keine Drucklecks.

- Lüfterwand-Drehzahl vs. Akustik/MTBF Ziele. Ventilatoren mit hohem statischem Druck sind Ihr Freund.

- Wenn die GPU-TDP hoch ist, sollten Sie flüssigkeitsgefüllte Kühlplatten oder ein höheres RU. Manchmal bieten 4 HE größere Kühlkörper und eine sauberere Kabelführung als 2 HE.

Wenn Ihr Einsatz geräumigere Thermostate oder mehr Steckplätze benötigt, sehen Sie sich die Familien von IStoneCase an:

- GPU-Server-Gehäuse - GPU-Server-Gehäuse (Katalog)

- 4U GPU Server-Gehäuse - 5U GPU Server-Gehäuse - 6U GPU Server-Gehäuse

Diese umfassen ATX/E-ATX-Anordnungen auch praktisch, wenn Sie einen atx-Server-Gehäuse Option mit mehr Spielraum.

Echte Workloads: VDI, Rendering, KI-Inferenz, Medientranskodierung

Man kauft keine Dual-Node-GPU-Boxen, weil man sie gerne haben möchte. Man kauft sie, um Arbeit auszuliefern:

- AI-Inferenz (Batch & Online): Mit Multi-GPU pro Knoten können Sie Modelle nach SKU anordnen und horizontal skalieren. Ideal für LLM-Serving, Vektorsuche und Computer Vision.

- Rendering & M&E: Tagsüber Remote-Arbeitsplätze; nachts Renderfarm. Mit den beiden Knoten können Sie interaktive Sitzungen von Warteschlangenaufträgen trennen.

- VDI: Packen Sie mehr Sitze pro RU, mit Single-Wide-GPUs, die zwar Strom verbrauchen, aber die Frames pushen.

- Transcode/Streaming: Die NVENC/NVDEC-Dichte ist optimal, wenn Sie viele Single-Slot-Karten in ein Gehäuse stecken.

- Rand/Abzweig: Robuste Racks lieben Dual-Node-Systeme, weil Ersatzteil- und Stromzufuhr knapp sind. Eine Box, zwei unabhängige Knoten = weniger LKW-Rollen.

Anspruch-Beweis-Wirkung (Tabelle)

| Behauptung (was wahr ist) | Nachweise/Spezifikationen (typisch) | Auswirkungen (na und) | Quelle: Typ |

|---|---|---|---|

| Dual-Node 2U/4U kann mehrere GPUs pro Knoten hosten | Pro Knoten PCIe 4.0 x16 Steckplätze; bis zu 3× doppelt breit oder 4-6× einfach breit je nach Layout | Hohe Dichte in kleinen RU; einfachere gemeinsame Nutzung von Strom und Lüftern | Datenblätter und Plattform-Kurzbeschreibungen der Hersteller |

| Gemeinsame PSUs und Lüfterwand reduzieren den Overhead | Redundant 2.x kW Gemeinsame PSUs; Lüfterwand mit hohem statischen Druck | Bessere Effizienz und weniger FRUs auf Lager | Datenblätter der Hersteller; Hinweise zum Einbrennen im Labor |

| OCP 3.0 NICs machen PCIe-Steckplätze frei | NIC als AIOM/OCP 3.0100/200G Optionen | Mehr GPUs passen, saubere Verkabelung, höhere Ost-West-BW | Bordhandbücher; Bauprotokolle |

| Thermals Gate GPU-Zahl | Lüfterwand CFM/SP → stabile GPU-Temperaturen unter Last | Verhindert Downclocking; längere Lebensdauer der Komponenten | Thermische Protokolle der Validierung |

| SKU-Sperre vermeidet Überraschungen | Gleiche Platinenrevision, Riser, Abdeckungen und Kabelsätze | Wiederholbare Produktionen; vorhersehbare Vorlaufzeiten | Beschaffungs-SOP und Stücklistenkontrolle |

| Doppelt genutzte Zyklen erhöhen den ROI | Tagsüber Arbeitsplätze, nachts Batch-Jobs | Höhere Auslastung ohne zusätzliche Racks | Kunden-PoC-Tagebücher |

| 4U/5U/6U können das Risiko der Hitze verringern | Höheres Gehäuse = größere Kühlkörper + einfachere Kabelführung | Geringere Lüfterdrehzahl, weniger Lärm, weniger thermische Zwischenfälle | Feldeinsätze; NOC-Berichte |

Hinweis: Die oben genannten Werte spiegeln branchenübliche Konfigurationen wider; die genauen Grenzwerte hängen von der von Ihnen gewählten Karte, den Risern und Kühlern ab.

Stücklisten auf Knotenebene (BOM), die Sie tatsächlich überprüfen sollten

- CPU-Sockel und Lane Map: Bestätigen Sie die Gesamtzahl der PCIe-Lanes nach NVMe und NICs.

- Steigleitungen und Schlitzabstände: Doppelt breite GPUs benötigen einen klaren 2-Slot-Abstand; achten Sie auf versteckte M.2-Wärmeschatten.

- OCP 3.0-Steckplatz: Reservieren Sie für Ihr 100G oder höheres Gewebe.

- Lüfterwand + Abdeckhaube: Die richtige Luftabschirmung kann die GPU-Temperaturen um zweistellige °C-Werte senken.

- PSU SKU: Gleiche Wattzahl, gleicher Wirkungsgrad, keine Vermischung von Revisionen.

- Firmware-Paket: BIOS/BMC/PCIe-Retimer-Versionen sperren. Nicht mischen und anpassen; es beißt.

Das ist langweiliger Papierkram, aber es hält die Flotten gesund.

Praktische Einsatzmuster (mit Fachjargon, aber nützlich)

- Disziplin Kaltgang/Warmgang: Füllungen eingebaut, Bürstenstreifen an den Kabelausschnitten, keine "Schweizer Käse"-Fronten.

- EVU-Haushalt vs. Wärme: Wenn 2U bei Ihrer Watt-pro-GPU knapp ist, Schritt zu 4U und aufhören, die Physik zu bekämpfen.

- Stoff-Layout2×100G pro Knoten (oder höher) zur Aufteilung Nord-Süd und Ost-West Datenverkehr; man denke an Dienstnetz + Speicherströme.

- MTBF und FRU-Bestand: Halten Sie einen Ersatzschlitten, PSUs und mindestens ein komplettes Riser-Kit pro Pod bereit.

- Beobachtbarkeit: Exportieren Sie BMC- und GPU-Telemetrie; erkennen Sie schleichende Lüfterausfälle vor der Drosselung. Das ist keine Raketenwissenschaft, aber es spart Nächte.

IStoneCase Optionen, wenn Sie OEM/ODM oder Massenware benötigen

Wenn Ihr Team einen Server-PC-Gehäuse oder atx-Server-Gehäuse abgestimmt auf Dual-Node-GPU-Builds, IStoneCase (IStoneCase - Der weltweit führende Hersteller von OEM/ODM-Lösungen für GPU-/Servergehäuse und Speicherchassis) liefert Fälle und Anpassungen für Rechenzentren, Algorithmus-Hubs, Unternehmen, MSPs, Forschungslabors und Entwickler. Beginnen Sie hier:

- Katalogübersicht: GPU-Server-Gehäuse

- Größer, cooler: 4U GPU Server-Gehäuse - 5U GPU Server-Gehäuse - 6U GPU Server-Gehäuse

- Workstation-freundliche GPU-Gehäuse: ISC GPU-Server-Gehäuse WS04A2 - ISC GPU-Server-GehäuseWS06A

- Durchgängig maßgeschneidert: Anpassung Server-Chassis-Dienst

Wir tun OEM/ODMGroßbestellungen und technische Anpassungen (Schienen, Führungssätze, Kabelführung, Schlittengriffe). Wenn Sie ein ausgefallenes Board oder einen seltsamen Riser haben, passen wir das Blech und die Luftstromführungen an. Das ist sozusagen unser Tagesgeschäft.

Schnelle Workload-Hardware-Zuordnung (Tabelle)

| Arbeitsbelastung / Szenario | GPU-Formfaktor des Knotens | NIC-Plan | Fahrgestell auswählen |

|---|---|---|---|

| KI-Schlussfolgerungen in großem Maßstab | 3× einfach breit (oder 2× doppelt breit) pro Knoten | Dual 100G; aufgeteilter Dienst vs. Speicher | 2U-Dual-Knoten, wenn TDP moderat; Sprung zu 4U GPU Server-Gehäuse wenn heiß |

| Ferngesteuerter Arbeitsplatz bei Tag, Rendering bei Nacht | 2-3× doppelte Breite pro Knoten | 100-200G; QoS auf Rendering-Warteschlange | 5U GPU Server-Gehäuse für leisere Ventilatoren |

| VDI-Farm | 4-6× einfach breit pro Knoten | 100G pro Knoten; L2/L3 in der Nähe der Benutzer | 6U GPU Server-Gehäuse wenn Sie kühlere Temperaturen benötigen |

| Rand-/Abzweigregale | 1-2× einfach breit pro Knoten | 25-100G; kompakte Optik | ISC GPU-Server-Gehäuse WS04A2 |

| Medien transkodieren | 4× einfach breit pro Knoten | 100G; Multicast/ABR-fähig | Katalog GPU-Server-Gehäuse oder kundenspezifisch |