Wenn Sie GPUs für mehrere Kunden auf derselben Hardware hosten, verkaufen Sie nicht wirklich “einen Server”. Sie verkaufen SLA, vorhersehbare Leistung und schnelle Wiederherstellung wenn etwas schiefgeht. Und ja, das Fahrwerk ist der Ort, an dem ein Großteil dieses Kampfes gewonnen oder verloren wird.

Ich möchte eines argumentieren: Multi-Tenant-GPU-Hosting sollte Gehäuse wie ein Ops-Team auswählen, nicht wie ein Gamer-Build. Ihre größten Feinde sind “laute Nachbarn”, thermische Drosselung und lange MTTR.

Hier sind die gleichen Entscheidungskriterien, die ich bei der Prüfung der Flotte eines Hosting-Anbieters verwende. Ich werde auch darauf hinweisen, wo IStoneCase natürlich hineinpasst, da sie Chassis für GPU- und Speicherprogramme in großem Maßstab bauen und anpassen.

Leistung: Groß genug, plus Redundanz

Multi-Tenant-Hosting hat einen unangenehmen “Blast Radius”. Ein einziges Problem mit einem Netzteil kann einen ganzen Host offline schalten, und plötzlich haben Sie 20 Tickets und einen Thread mit Rückerstattungsforderungen.

Was Sie wollen:

- Redundante Netzteilunterstützung (Denken Sie an eine N+1-Mentalität, nicht an “Hoffen und Beten”).

- Saubere Stromverteilung damit die Techniker nicht um 2 Uhr morgens das falsche Kabel herausziehen.

- Ausreichend Spielraum für Spitzenlasten, nicht nur “es bootet”

Eine reale Problemsituation: Ein Mieter startet einen umfangreichen Trainingsauftrag, die GPUs erreichen Spitzenwerte, der Host wird instabil, und dann stellt Ihr Bereitschaftsdienst fest, dass die Wahl des Gehäuses zu einer chaotischen Stromversorgung geführt hat. Das ist kein Pech. Das ist eine Produktdesign-Schuld.

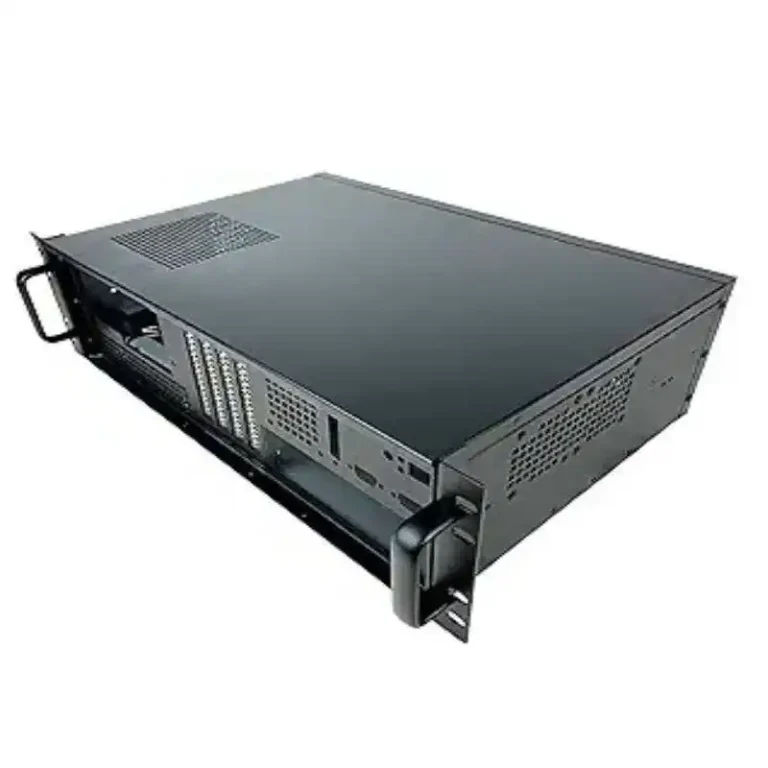

Wenn Sie eine dedizierte Multi-GPU-Flotte spezifizieren, beginnen Sie mit einer speziell entwickelten GPU-Server-Gehäuse Linie, anstatt einen generischen Turm zu zwingen, sich wie ein Rechenzentrumsknoten zu verhalten.

Kühlung: Hot-Swap-fähige Lüfter und Luftstrom von vorne nach hinten

Eine Multi-Tenant-Box ist im Grunde genommen eine Wohngemeinschaft. Die Wärme ist der laute Mitbewohner. Wenn Sie die Luft nicht richtig umwälzen können, werden Sie Folgendes feststellen:

- GPU-Taktfrequenzen sinken (Kunden bezeichnen dies als “Sie drosseln mich”)

- Weitere Ventilatorausfälle

- Mehr zufällige Instabilität unter Last

Suchen Sie nach:

- Luftstrom von vorne nach hinten das zu den Layouts für Warmgang/Kaltgang passt

- Hot-Swap-fähige Lüfterwände (schneller Austausch = geringere MTTR)

- Filter und Leitbleche, die nicht wie ein nachträglicher Einfall wirken

Ein einfaches Beispiel aus den IStoneCase-Spezifikationen: Einige 4U-GPU-Gehäusekonfigurationen verwenden eine Multi-Lüfter-Konfiguration mit Temperaturregelung und viel PCIe-Platz (die genauen Layouts variieren je nach Modell, aber der Punkt ist, dass sie “für Wärme gebaut” und nicht “für Wärme dekoriert” sind). Wenn Sie “Rack First”-Denken benötigen, ist das server rack pc gehäuse Der Stilkatalog ist eine gute Grundlage.

Passformprüfung: GPUs, Steckplatzabstand und Kabelabstand

Das klingt offensichtlich. Es zerstört immer noch Projekte.

Bevor Sie 50 Fahrgestelle kaufen, müssen Sie folgende Frage beantworten:

- Passen Ihre GPUs physisch (Länge, Dicke, Richtung des Netzsteckers)?

- Verlaufen die Stromkabel ohne sich stark zu verbiegen unter der Abdeckung und den Seitenwänden?

- Kann man eine GPU warten, ohne die Hälfte des Geräts zu entfernen?

Beim Multi-Tenant-Hosting wird eine “enge Passform” zu einer Betriebssteuer. Sie benötigen für jeden Eingriff zusätzliche Minuten. Das summiert sich schnell. Außerdem neigen enge Konstruktionen dazu, heißer zu werden. Sie müssen also häufiger eingreifen. Ein Teufelskreis.

Wenn Ihre Flotte gemischte GPU-SKUs verwendet, orientieren Sie sich an der schlechtesten Karte, nicht an der besten.

Erweiterung: PCIe-Layout für GPUs, NICs und Speicher

Die meisten Hosting-Anbieter vermasseln das, indem sie denken: “Mehr GPUs = fertig.”

Noch nicht fertig. In einer Multi-Tenant-Umgebung benötigen Sie in der Regel auch:

- Hochgeschwindigkeits-Netzwerkkarten (Mieterverkehr, Speicherverkehr, Steuerungsebene ... das summiert sich)

- Manchmal zusätzliche PCIe für HBAs oder DPUs

- Ausreichend Lanes und sinnvolle Slot-Platzierung, damit NICs nicht hinter GPUs zurückbleiben

Faustregel: Die Wahl Ihres Chassis sollte Folgendes unterstützen: Anzahl der verkauften GPUs, plus das Netzwerk, das Sie benötigen, um die Latenz konstant zu halten.

Hier kommt es auf die richtige Server-PC-Gehäuse Die Familie (mit vorhersehbaren RU-Größen und Erweiterungsmustern) schlägt zufällige Verbrauchergehäuse jedes Mal.

Speicher: NVMe + Hot-Swap-Laufwerksschächte für schnelle Operationen

Selbst wenn Sie “GPUs verkaufen”, prägt der Speicher dennoch das Kundenerlebnis:

- Modellgewichte, Datensätze, Caches

- Bilder, Schnappschüsse, Protokolle

- Lokaler Scratch, der Ihr Netzwerk vor Überlastung schützt

Für Multi-Tenant gilt folgende Priorität:

- Hot-Swap-Schächte (Tauschen ohne Ausfallzeiten)

- Backplane-Optionen, die zu Ihrem Speicherplan passen (SATA/SAS/NVMe, je nach Ihrem Design)

- Sauberer Servicezugang von vorne

Wenn Sie GPU-Hosts und eine Speicherebene betreiben, kombinieren Sie diese mit NAS-Geräte Das Chassis sorgt für eine übersichtliche Architektur: Rechenknoten bleiben Rechenknoten, Speicherknoten bleiben Speicherknoten.

Multi-Tenant-Bereitstellung: MIG, vGPU oder Time-Slicing

Dieser Teil betrifft nicht nur das Gehäuse, sondern beeinflusst auch die Entscheidung, welches Gehäuse Sie kaufen sollten.

Grundsätzlich gibt es drei “Produktformen”:

- Hardware-Partitionierung (MIG-Stil): bessere Isolierung, vorhersehbarere QoS

- Virtuelle GPU (vGPU): stark für VM-basierte Mandanten, erfordert jedoch auch eine gewisse Reife in Bezug auf Treiber/Betrieb

- Zeiteinteilung: günstig und einfach, aber das Risiko eines “lauten Nachbarn” ist real

Hier ist die Pointe: Wenn Sie vorhersehbare Segmente verkaufen, muss Ihr Chassis vorhersehbare thermische Eigenschaften unterstützen. Andernfalls erfüllen Sie zwar auf dem Papier die “GPU-Slice-Spezifikationen”, verlieren jedoch bei realer Auslastung an Konsistenz, da das Gerät heiß läuft.

Wenn Sie ein Angebot auf der Grundlage bekannter Komponenten erstellen, ist ein atx-Server-Gehäuse Dieser Ansatz kann sinnvoll sein, solange Sie die Luftstrom- und Wartungsvorschriften weiterhin einhalten.

Realität der Anlage: Leistungsdichte und Wartungsfreundlichkeit von Racks

Sie können das beste Chassis der Welt kaufen und trotzdem Probleme haben, wenn Sie den Raum ignorieren.

Zwei Fragen, die ich immer stelle:

- Können Ihre Racks tatsächlich die Leistung und Wärme bewältigen, die Sie einbauen möchten?

- Kann ein Techniker Teile schnell austauschen, ohne “Rack-Jenga” zu spielen?

Dies ist der Ort, an dem Schienen sind langweilig, aber riesig. Werkzeuglose Schienen helfen, dumme Fehler zu vermeiden, den Austausch zu beschleunigen und die Hände in engen Gängen zu schützen. Wenn Sie einen reibungsloseren Wartungszyklus wünschen, schauen Sie sich ein geeignetes Modell an. Fahrgestellführungsschiene Einrichtung anstelle von nicht passenden Universalschienen.

Auch die Wartungsfreundlichkeit ist ein geschäftliches Merkmal. Weniger Zeit pro Reparatur bedeutet weniger Ausfallzeiten pro Mieter. Das ist echter Mehrwert.

Entscheidungstabelle: Auswahl eines Multi-Tenant-GPU-Gehäuses (Ops-First)

| Entscheidungssäule | Warum dies beim Multi-Tenant-Hosting wichtig ist | Was im Fahrgestell zu überprüfen ist | “Typ ”Quelle“ (ohne Übertreibung) |

|---|---|---|---|

| Redundante PSU | Verringert den Explosionsradius, schützt SLA | Redundante Netzteilunterstützung, übersichtliche Verkabelung | Rechenzentrumsbetrieb |

| Hot-swap-fähige Lüfter | Schnellere MTTR, weniger vollständige Host-Ausfälle | Lüfterwanddesign, Hot-Swap, Luftstrom von vorne nach hinten | Normen für das Design von HPC/KI-Gehäusen |

| GPU-Passform + Freiraum | Verhindert Build-Fehler und Hotspots | Steckplatzabstand, Deckelabstand, Kabelführung | Integrationslektionen aus dem Flottenbetrieb |

| PCIe-Layout | Vermeidet NIC-Engpässe und Wärmefallen | GPU + NIC-Platzierung, Riser-Optionen, Anzahl der Steckplätze | Netzwerk- und GPU-Hosting-Modelle |

| NVMe + Hot-Swap-Einschübe | Beschleunigt die Wiederherstellung, unterstützt Cache/Scratch | Hot-Swap-Einschübe, Auswahl der Backplane, Zugang von vorne | Best Practices für Speicheroperationen |

| MIG/vGPU/Zeitscheibenmodell | Änderungen der QoS-Erwartungen | Thermische Stabilität, Wartungszugang, Ausdehnungsraum | Herstellerdokumentation + SRE-Praxis |

| Rails + Dienstzugriff | Reduziert menschliche Fehler und Ausfallzeiten | Werkzeuglose Schienen, Tiefenkompatibilität | Realität der Wartung vor Ort |

Wo iStoneCase zum Einsatz kommt: OEM/ODM, Großprogramme und schnellere Markteinführungen

Wenn Sie ein Hosting-Anbieter sind, brauchen Sie nicht nur “eine gute Box”. Sie brauchen:

- eine wiederholbare Stückliste,

- Stabile Lieferung für Sammelbestellungen,

- und die Möglichkeit, Details anzupassen, ohne die gesamte Plattform neu gestalten zu müssen.

Aus diesem Grund würde ich IStoneCase für den Flottenaufbau auf der Shortlist behalten. Das Unternehmen bietet GPU-Gehäuse, Speichergehäuse, Rackmount-Optionen und Schienen an und übernimmt außerdem OEM/ODM-Dienstleistungen wenn Sie Ihre eigene Front, Ihre eigene interne Halterungskarte oder Ihren eigenen Luftstromplan benötigen.

Wenn Sie eine schnelle Möglichkeit suchen, die RU-Höhe an Ihren Rollout-Plan anzupassen, dann ist dies Computergehäuse Server Eine Seite im Stil einer Checkliste ist ein praktischer Ausgangspunkt.