Sie haben also gerade ein ganzes Rack voller hochmoderner GPUs gekauft - vielleicht die A100s oder die neuen Hopper H100s. Prima! Sie haben das beste Silizium der Welt, um Ihr nächstes Sprachmodell zu trainieren. Aber warten Sie einen Moment. Wenn Sie diese Hochleistungsbiester in ein altes, verstaubtes Standard-ATX-Servergehäuse stecken, Im Grunde genommen setzen Sie Ihren besten Spieler beim Meisterschaftsspiel auf die Bank.

Im Ernst: Das Servergehäuse ist mehr als nur ein Metallkasten. Für die KI-Forschung und das High-Performance-Computing ist das Gehäuse ein genau abgestimmtes Wärme- und Energie-Ökosystem. Ohne die richtige Struktur werden Sie nicht die maximale Leistung aus Ihrer teuren Hardware herausholen können. Sie könnten sie sogar beschädigen. Wir müssen darüber sprechen, warum ein spezielles Server-Rack-PC-Gehäuse kein Nice-to-have ist; es ist eine nicht verhandelbare Anforderung.

Halten Sie Ihr Silizium kühl: Das thermische Schlachtfeld

Dies ist der größte Schmerzpunkt für jeden Entwickler oder Rechenzentrumsleiter: Hitze.

Verhinderung von thermischem Throttling durch überlegene Kühlung

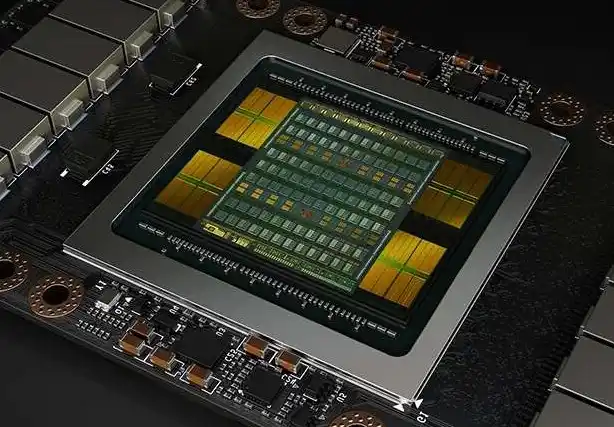

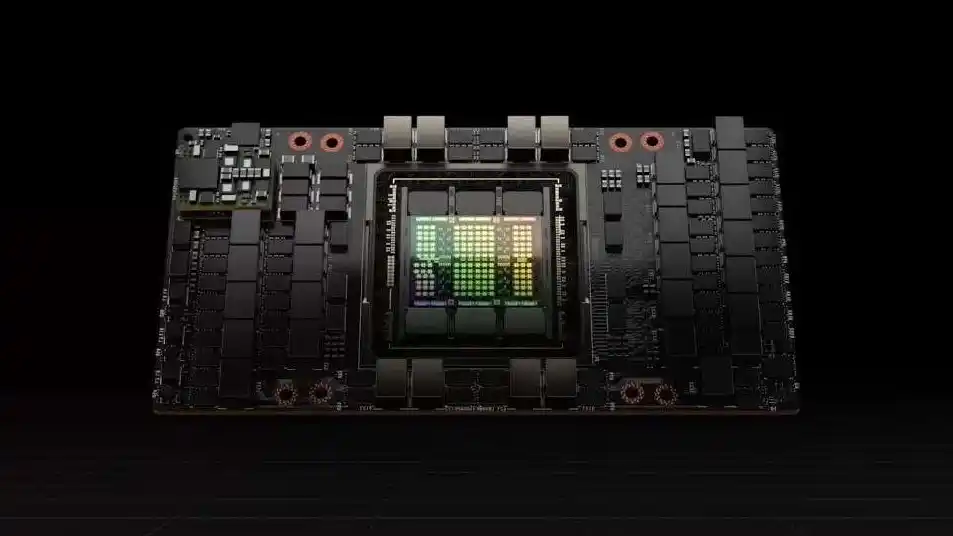

High-End-GPUs erzeugen eine unglaubliche Menge an Wärme. Eine einzelne Karte kann weit über 350 Watt Leistung, und ein typischer AI-Server fasst 8 bis 10 davon auf einmal . Stellen Sie sich vor, Sie betreiben zehn Haartrockner in einem kleinen Schrank - das ist in etwa das, was in einem nicht optimierten Computergehäuse-Server passiert.

Ein allgemeiner Fall ist einfach kann nicht genug Luft bewegen um mitzuhalten.

Dies führt zu einem Prozess namens thermische Drosselung. Ihr intelligenter Grafikprozessor merkt, dass es zu heiß wird, und bremst automatisch die Leistung, um sich selbst vor dem Schmelzen zu bewahren. Das bedeutet, dass Ihr mehrtägiger Trainingslauf jetzt eine zusätzliche Woche dauert. Sie verschwenden Zeit und Strom, und Ihre Leistung leidet.

GPU-optimierte Gehäuse, wie die Istonecase Entwürfe GPU-Server-Gehäuse, verwenden ein fortschrittliches, speziell entwickeltes Luftstromdesign. Sie bieten Hoch-CFM-Ventilatoren (Kubikfuß pro Minute) und spezielle Kanäle, um sicherzustellen, dass die kühle Luft jede einzelne Karte erreicht. Sie kühlen nicht nur das System; sie verwalten aktiv das thermische Profil damit Ihre Karten immer mit der höchsten Taktrate laufen können.

Rack-Dichte ist keine Option, sondern die Voraussetzung

Bei der Skalierung eines KI-Zentrums zählt jeder Zentimeter Platz im Rack. Sie müssen die Rechenleistung maximieren, die Sie in einem einzigen Schrank unterbringen können.

Anpassung an GPU-Konfigurationen mit hoher Dichte

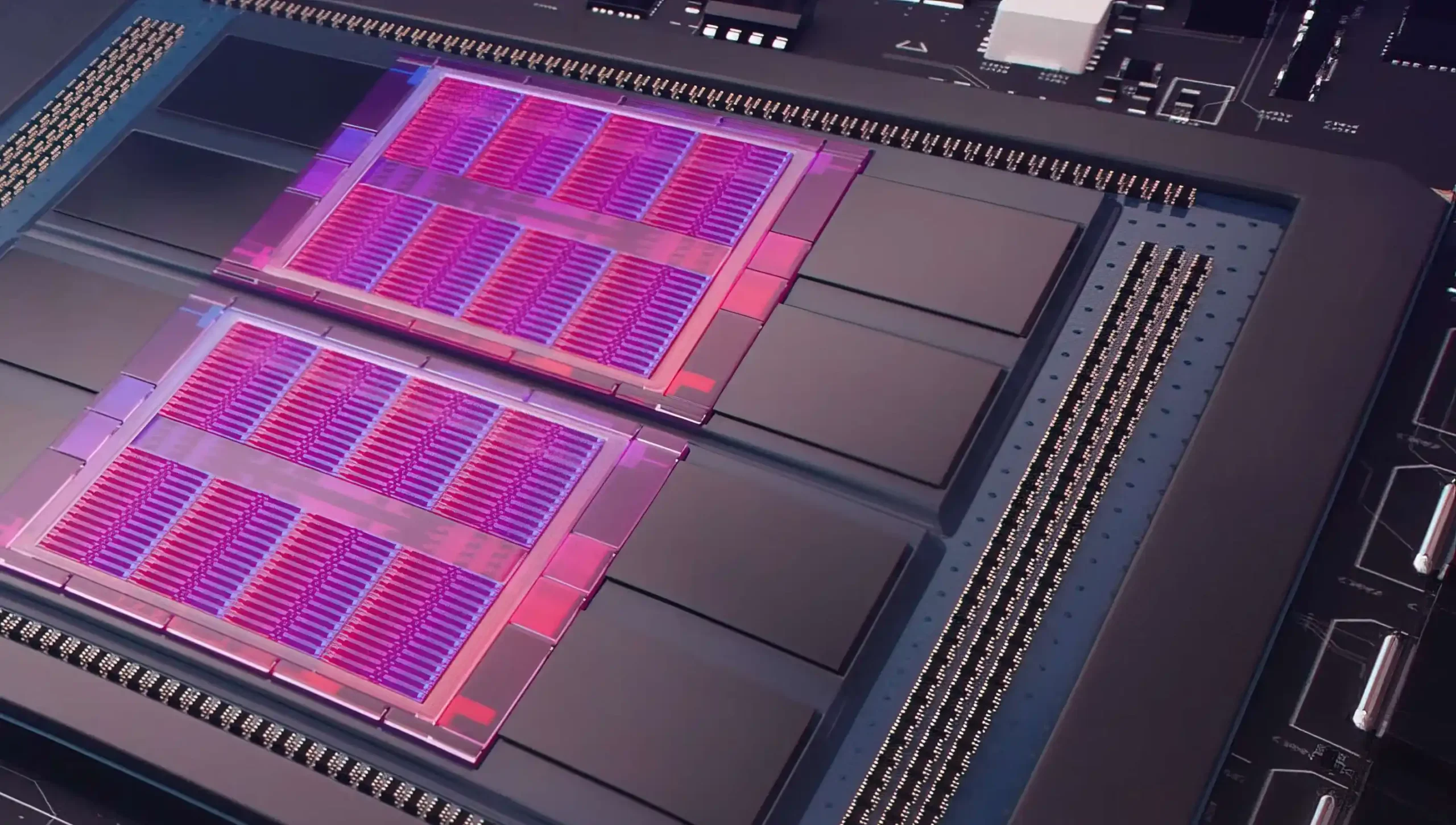

Um ernsthafte KI-Probleme anzugehen - wie das Training eines komplexen Bildverarbeitungsmodells oder einer neuen LLM-Grundlage - benötigen Sie Dutzende, vielleicht sogar Hunderte von parallel arbeitenden GPUs. Das bedeutet, dass Sie ein einziges Server-PC-Gehäuse benötigen, das viele Karten aufnehmen kann.

Diese speziellen Chassis sind physisch so konzipiert, dass sie Folgendes unterstützen bis zu 13 GPUs mit doppelter Breite in einem Standard-Serverschrankformat. Entscheidend ist, dass sie die richtige räumlicher Abstand-oftmals 75 mm oder mehr zwischen den Karten. Dieser Abstand ist wichtig, um sicherzustellen, dass der hohe CFM-Luftstrom, über den wir gerade gesprochen haben, tatsächlich zwischen die Karten gelangt und nicht an ihnen vorbeigeht. Sie können diese Art von Dichte einfach nicht erreichen und Kühlung in einem standardmäßigen, handelsüblichen Gehäuse.

Sicherstellung einer stabilen Stromversorgung

Moment mal. Wenn zehn GPUs auf Hochtouren laufen, ist die Leistungsaufnahme des Systems enorm. Dabei geht es nicht nur um die Gesamtwattzahl, sondern auch um die Stabilität.

Optimierte Gehäuse werden entwickelt mit verbesserte Stromversorgungssysteme (PDS) um den massiven Strom zu bewältigen. Sie sind speziell für robuste PDU (Power Distribution Unit) Integration, was in der Branche als Abkürzung für “Das Ding wird nicht abstürzen, wenn Sie 100% Last erreichen” gilt. Stromschwankungen oder Stromausfälle können einen Datensatz sofort beschädigen oder einen Trainingscheckpunkt zerstören, den Sie Tage oder Wochen lang erstellt haben. Das richtige Gehäuse ist Ihr elektrische Ausfallsicherung, und garantiert so die saubere, stabile Energie, die für Non-Stop-Rechnungen erforderlich ist. Dieses Maß an Zuverlässigkeit ist für Rechenzentren und Algorithmenlabore von entscheidender Bedeutung Rackmount-Gehäuse.

Der Geschäftswert: Verlässlichkeit und Zukunftssicherheit

Wir wissen, dass Forschung eine Investition ist. Jede Minute Systemausfallzeit kostet Sie nicht nur Zeit, sondern auch potenzielle Durchbrüche. Sie können nicht innovativ sein, wenn Ihre Infrastruktur ständig ausfällt.

Gewährleistung der strukturellen Integrität und Zuverlässigkeit

Diese Hochleistungs-GPUs sind klobig, und sie sind schwer. Wenn Sie ein Rack über den Boden eines Rechenzentrums transportieren oder wenn die Lüfter auf Höchstgeschwindigkeit drehen, ist das eine physische Belastung.

Ein hochwertiges Server-Rack-PC-Gehäuse Server-Gehäuse Merkmale verstärkte PCIe-Steckplätze und ein robustes Gehäusedesign . Dies verhindert physische Schäden, verbogene Karten oder Verbindungsausfälle bei kontinuierlichem, hochintensivem Betrieb. Diese strukturelle Integrität bietet Ihnen die Zuverlässigkeit, die Sie für 24/7-Forschungsarbeiten unbedingt benötigen.

Maximierung der Effizienz und Skalierbarkeit von Rechenzentren

Für eine große Forschungseinrichtung oder einen Hyperscale-Cloud-Anbieter ist Platz Geld.

Optimierte Gehäuse gewährleisten die beste Effiziente Nutzung der Regalfläche möglich. Wir bei Istonecase wissen, dass sich Bedürfnisse ändern, und bieten maßgeschneiderte Lösungen Personalisierung und OEM/ODM-Fertigung, die ein modulares Baukastensystem bieten OEM/ODM-Lösungen. Das bedeutet, dass wir eine Lösung entwickeln können, die die heutige PCIe Gen 5.0 unterstützt und Folgendes bietet PCIe-Lane-BifurkationsfunktionenSo können Sie problemlos die nächste Hardware-Generation einbauen, ohne das gesamte System zu entkernen. Das nennen wir Zukunftssicher Ihre erhebliche Hardware-Investition.

Zusammenfassende Tabelle: Der kritische technische Unterschied

| Spezifisches Argument | Warum es für die KI-Forschung unerlässlich ist | Quelle/Behörde (Beispiel) |

| Optimiertes Wärmemanagement | Verhindert thermische Drosselung durch das Management der massiven Hitze von mehreren 350W+ GPUs, die maximale Verarbeitungsgeschwindigkeit und 24/7 Stabilität gewährleisten. . | Fortschrittliche Kühllösungen mit hohem CFM-Luftstrom und 75 mm+ Abstand zwischen den Karten. . |

| Unterstützung für hohe GPU-Dichte | Ermöglicht es den Forschern, die notwendigen 4 bis 13 GPUs die für komplexes Deep Learning, LLM-Training und massive Parallelverarbeitung benötigt werden. . | Das Gehäuse unterstützt bis zu 10-13 GPUs mit doppelter Breite in einem kompakten Rack-Formfaktor. . |

| Robuste Leistungsarchitektur | Bietet die stabile Leistung mit hoher Wattzahl die von mehreren gleichzeitig laufenden Grafikprozessoren benötigt werden, um Systeminstabilität und Datenbeschädigung zu vermeiden. . | Verbesserte Stromversorgungssysteme (PDS) und notwendige PDU-Integration . |

| Strukturelle & Schlitzbewehrung | Unterhält Hardware-Integrität und verhindert physische Schäden oder Verbindungsprobleme durch das Gewicht und die Vibrationen schwerer, ständig laufender GPUs. . | Verstärkte PCIe-Steckplätze und robustes Gehäusedesign für den 24/7-Betrieb. . |

Szenarien der realen Welt: Wo ein allgemeiner Fall scheitert

Hier ist ein einfaches Gedankenexperiment: Stellen Sie sich vor, Sie trainieren ein riesiges, transformatorbasiertes Modell. Sie haben sechs Tage Zeit für einen achttägigen Lauf. Die Kosten sind hoch, aber das Ergebnis steht unmittelbar bevor. Plötzlich überhitzt die GPU in der Mitte des Stapels, weil das allgemeine Kühlsystem die Last nicht bewältigen konnte. Er drosselt. Durch diesen einen Fehler wird die empfindliche Synchronisierung der anderen sieben Karten gestört, was zu einem Segmentierungsfehler und zum Absturz des gesamten Auftrags führt. Sie haben gerade sechs Tage verloren. Das ist ein enormer Faktor!

Das ist keine Übertreibung, sondern eine häufige Geschichte in Labors, die versuchen, an der falschen Stelle zu sparen.

Sie investieren in die besten Algorithmen, die spezialisiertesten Datenwissenschaftler und die teuersten GPUs. Lassen Sie nicht zu, dass Ihre Infrastruktur das schwächste Glied wird.

Für Rechenzentren, Algorithmuszentren und technische Entwickler in aller Welt Unsere Kunden, IstoneCase ist der weltweit führende Hersteller von OEM/ODM-Lösungen für hochwertige, leistungsstarke GPU/Server-Gehäuse und Speicherchassis Über uns. Wir schaffen die Umgebung, in der Ihr teures Silizium genau das tut, was es soll.

Wenn Ihre Forschung auftragskritisch ist, brauchen Sie ein Gehäuse, das für den Auftrag gebaut wurde. Sie müssen einfach kann es sich nicht leisten, Kompromisse zu machen.