La chaleur tue le temps de fonctionnement.

Je continue de voir des équipes dépenser des sommes à six chiffres pour des GPU, puis “économiser de l'argent” sur le boîtier qui détermine si ces GPU fonctionnent conformément aux spécifications, s'ils sont bridés pendant des mois ou s'ils meurent prématurément - parce que les voies d'écoulement d'air, l'impédance, l'acheminement des câbles et l'ergonomie des services n'ont pas été traités comme de l'ingénierie, mais comme de la tôlerie.

Pourquoi continuer à prétendre que le châssis n'est qu'un simple emballage ?

Voici la vérité qui dérange : “AI-ready” est un autocollant, pas une spécification. Et l'autocollant cache généralement les mêmes compromis : des parois de ventilateurs qui ne peuvent pas maintenir la pression statique sous les filtres, des baies d'alimentation qui manquent d'admission et des agencements qui transforment chaque tâche de maintenance en un temps d'arrêt.

La véritable contrainte n'est pas le calcul du GPU. C'est la densité de puissance + les températures + l'accès.

Trois chiffres ont plus d'importance que votre dossier marketing : watts, pascals, minutes.

Les watts, parce que les GPU ne négocient pas. L'offre de NVIDIA L4 est une 72W Il est indulgent et facile à manipuler sur le papier. Mais vos cartes d'inférence “sérieuses” sautent fort : L40S listes Puissance maximale de 350 W. Et les systèmes de classe H100 peuvent pousser jusqu'à 700W (SXM) ou 350-400W (PCIe, configurable).

Pascals, parce que le débit d'air n'est pas “plus de ventilateurs”. C'est un budget de pression. Les filtres, les grilles, les coudes serrés, les faisceaux de câbles mal placés - chacun d'entre eux consomme de la pression statique et transforme tranquillement votre “refroidissement de châssis de serveur GPU à haut débit d'air” en turbulences chaudes.

Des minutes, parce que l'inférence en périphérie et sur site n'est pas un passe-temps. Si votre technicien a besoin de 45 minutes et de trois outils pour extraire un nœud, vous n'avez pas d“”opérations". Il s'agit d'un vœu pieux.

Si vous vous approvisionnez, commencez par un fournisseur qui traite les châssis comme un produit, et non comme un article de base, comme le fait iStoneCase dans le cadre de son programme d'achat de châssis. constructions sur mesure reconnaît au moins que les configurations de GPU ne sont pas uniformes (voir leur propre cadrage sur un approche du fabricant de châssis de serveurs GPU sur mesure).

Edge vs on-prem : même silicium, modes de défaillance différents

La poussière détruit les ventilateurs.

Les déploiements d'IA en périphérie sont étouffés par les particules, les éclaboussures, les vibrations et le routage paresseux des câbles, tandis que les racks sur site vous punissent avec une charge thermique soutenue et une fréquence de service ; les objectifs de conception se chevauchent, mais les façons d'échouer sont totalement différentes.

Alors pourquoi les acheteurs acceptent-ils de se contenter d'un “châssis à crémaillère, mais plus petit” ?

Si vous faites du edge, arrêtez d'envoyer des cadres ouverts dans des pièces sales en espérant que tout se passe bien. Utilisez une stratégie de boîtier qui tient compte de la saleté du monde réel et des mains humaines - iStoneCase le souligne sans ambages dans son Boîtier de serveur industriel mural pour les réseaux d'usine/OT.

Si vous travaillez sur site, traitez le rack comme une chaîne de production : échangez, glissez, remplacez, enregistrez. Rails est plus important que les gens ne l'admettent, car personne n'assure le service d'un nœud de 30 à 50 kg de manière gracieuse sans eux (voir rails de guidage pour châssis de montage en rack).

Une bonne raison pour que la situation s'aggrave en 2024

Le pouvoir se resserre.

Le gouvernement américain considère désormais publiquement les centres de données comme un problème national en matière d'électricité : le DOE a résumé que les centres de données américains utilisaient ~4,4% de l'électricité totale des États-Unis en 2023, et devraient atteindre ~6,7% à 12% d'ici 2028-avec une utilisation estimée à 176 TWh (2023) et 325-580 TWh (2028).

En cas de tension sur le réseau, que pensez-vous qu'il arrive à votre marge de manœuvre thermique et aux contraintes liées aux installations ?

Ce communiqué du ministère de l'énergie n'est pas un billet de blog ; il s'agit d'un coup de semonce institutionnel lié à un rapport du LBNL créé en réponse à la loi sur l'énergie de 2020.

Conception d'un châssis de serveur GPU : la liste de contrôle que les vendeurs détestent

Vous voulez la réponse à la question “comment concevoir” ? Voici ce que je recherche lorsque j'essaie de distinguer une ingénierie de châssis sérieuse d'un remplissage de catalogue.

1) Architecture du flux d'air, et non nombre de ventilateurs

- Écoulement en ligne droite est plus efficace que l'intelligence. Le front-to-back est ennuyeux parce qu'il fonctionne.

- Partitionner les zones chaudes : GPU, CPU, PSU(s), NVM - chacune doit avoir un chemin d'accès défini.

- Si vous avez besoin de filtres (bord), concevez le budget pression. autour de et non pas des clips à la sauvette.

2) La hauteur est une décision thermique (2U/4U/6U n'est pas une question d'esthétique).

- 2U peut fonctionner pour l'inférence si vous êtes discipliné (cartes à faible TDP, moins de GPU à double largeur, ventilateurs à plus haut régime, plus de bruit).

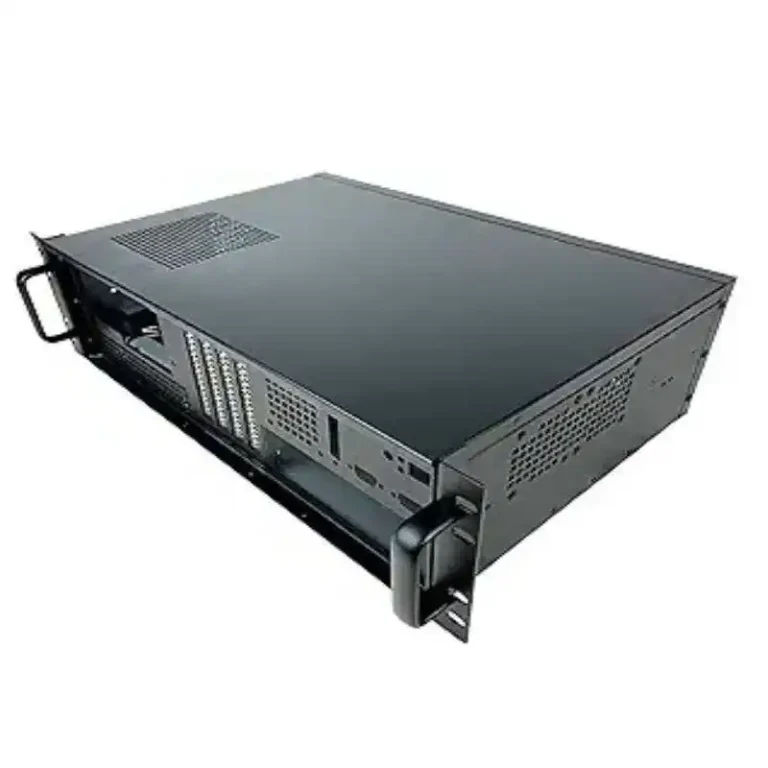

- 4U est la solution par défaut pour les solutions mixtes GPU + stockage + services - c'est la raison pour laquelle de nombreux acheteurs commencent à naviguer sur le site Options de boîtier rackable 4U.

- 6U est l'endroit où l'on va lorsque la densité + la circulation de l'air + la réalité du câblage s'entrechoquent - plus de volume, de meilleurs conduits, moins de “gymnastique d'accès” (cf. Liste des boîtiers de serveurs GPU 6U).

3) Matériaux et rigidité : les vibrations sont un tueur silencieux au bord de l'eau.

La conception d'un boîtier de serveur GPU robuste ne se limite pas à un “métal plus épais”. C'est de la rigidité aux bons endroits, moins de points de résonance, un montage adéquat et ne pas prétendre qu'un support de GPU est une poutre structurelle.

Je ne mâche pas mes mots : Je fais davantage confiance aux vendeurs lorsqu'ils publient les caractéristiques réelles des matériaux (épaisseur, qualité de l'acier, pièces en aluminium) au lieu d'utiliser des adjectifs. Même sur les pages produits, les spécificités l'emportent sur les détails.

4) Alimentation électrique et géométrie des câbles

- La prise en charge de deux blocs d'alimentation n'est pas une question d'entreprise, c'est une question de contrôle des risques.

- Le passage des câbles ne doit pas empiéter sur les voies d'admission.

- Prévoyez des connecteurs d'alimentation pour le GPU (8 broches/16 broches) afin qu'ils ne deviennent pas des obstacles à la circulation de l'air.

5) Conception des services : l'accès est une caractéristique de performance

Si votre technicien ne peut pas remplacer rapidement un plateau de ventilateur, vous aurez un refroidissement dégradé “temporairement” jusqu'à ce qu'il devienne permanent.

C'est là que les rails et les modèles sans outils cessent d'être “agréables à avoir”. Encore une fois : rails de guidage du châssis sont une petite partie qui a un impact opérationnel considérable.

Exigences en matière de châssis d'inférence Edge AI ou sur site

| Attribut de conception | Châssis de serveur Edge AI | Boîtier de serveur GPU en rack sur site | Qu'est-ce qui se brise si vous l'ignorez ? |

|---|---|---|---|

| Filtration de l'air | Admission filtrée, remplacement facile des filtres, plan de ventilation tenant compte de la pression | Souvent non filtrés, optimisez la circulation de l'air. | Les ventilateurs se bouchent (bord) ou des points chauds se forment (grille) |

| Chocs/vibrations | Montage rigide, charge en porte-à-faux minimisée, maintien sécurisé de la carte | Environnement généralement stable | Problèmes d'assise des GPU/PCIe, microfissures au fil du temps |

| Budget acoustique | Généralement contraint (à proximité de personnes) | Souvent moins contraint (salle des serveurs) | Ventilateurs Teams “cap” → étranglement thermique |

| Accès au service | Accès frontal, options de montage mural/de faible profondeur | Rails coulissants, échange à chaud si possible | Temps d'arrêt prolongé par incident |

| Marge de manœuvre thermique | Charges irrégulières + air pollué + température ambiante plus élevée | Charges soutenues + limites de l'installation | Accélération, puis panne |

| Pression de conformité | Localité des données, pratiques de sécurité de l'OT | Auditabilité, documentation, gouvernance | Vous êtes bloqué par le risque/la conformité |

La conformité est le moteur discret de l'inférence on-prem

Le règlement mord.

Le choix d'un serveur d'inférence d'IA sur site n'est pas seulement lié à la latence et au coût, mais aussi à la gouvernance, à la documentation et à la question de savoir qui sera blâmé lorsque les modèles se comportent mal dans les flux de travail réglementés.

Vous voulez une raison concrète ?

Commencez par le site du NIST Cadre de gestion des risques liés à l'IA 1.0 (publié sous le titre NIST AI 100-1 en 2023), qui est en fait un signal pour les entreprises : gérer le contexte, les impacts et la responsabilité comme des adultes.

Ajoutez à cela le marteau juridique de l'Europe : Règlement (UE) 2024/1689 (la loi sur l'IA de l'UE) adoptée 13 juin 2024-une vraie loi avec de vraies sanctions et des attentes en matière de documentation.

Lorsque les équipes chargées de la conformité deviennent nerveuses, elles posent une question prévisible : “Pouvons-nous conserver des données sensibles à l'intérieur de notre périmètre contrôlé ?” Cette question rapproche l'inférence de la périphérie ou sur site, et soudain vos choix de châssis cessent d'être du “matériel informatique” pour devenir une “infrastructure de risque”.”

FAQ

Qu'est-ce qu'un châssis de serveur GPU ?

Un châssis de serveur GPU est la plateforme mécanique et thermique (tôle, rails, flux d'air, distribution d'énergie et ouvertures d'E/S) qui permet à une ou plusieurs cartes accélératrices de fonctionner à la puissance nominale - souvent de 72 W à 700 W par GPU - à l'intérieur d'un rack ou d'un boîtier de bord, sans ralentissement ni défaillance.

En pratique, il s'agit également de votre système de maintenance : la vitesse à laquelle vous pouvez remplacer les ventilateurs, réinstaller les cartes et maintenir le flux d'air propre.

Qu'est-ce qui différencie un châssis de serveur Edge AI d'un boîtier de serveur GPU monté en rack ?

Un châssis de serveur Edge AI est un boîtier compatible avec les GPU, conçu pour l'air sale, les températures ambiantes élevées, les vibrations et un accès limité aux services, tandis qu'un boîtier de serveur GPU monté en rack suppose un environnement contrôlé et optimise la densité, les rails standardisés et le flux d'air prévisible d'avant en arrière dans les racks de 19 pouces.

Si vous déployez la périphérie comme s'il s'agissait d'un centre de données, vous apprendrez à vos dépens la leçon du “filtre et de la pression”.

Comment dimensionner le refroidissement pour des GPU de 350W-700W dans des designs 2U/4U ?

Le dimensionnement du refroidissement consiste à faire correspondre la charge thermique totale (pertes GPU+CPU+PSU), l'augmentation de température admissible et la capacité de pression statique du ventilateur à une trajectoire de flux d'air définie afin que les accélérateurs puissent soutenir les horloges d'accélération sans franchir les seuils d'étranglement sous l'impédance réelle (filtres, grilles, faisceaux de câbles) et les températures d'entrée les plus défavorables.

Règle d'or : concevoir pour le jour méchant, pas pour le jour du laboratoire.

Quand le refroidissement liquide vaut-il la peine dans un boîtier de serveur GPU ?

Le refroidissement liquide est une approche d'élimination de la chaleur dans laquelle les boucles de refroidissement déplacent l'énergie thermique des GPU/CPU vers les radiateurs ou l'eau de l'installation, permettant une densité de puissance soutenue plus élevée que le refroidissement par air dans le même volume, en particulier lorsque le flux d'air est contraint par les limites de bruit, la filtration de la poussière, ou les exigences extrêmes du TDP du GPU.

Si vous empilez des cartes de grande puissance et que votre flux d'air est compromis, les liquides cessent d'être exotiques et deviennent des mathématiques.

Comment les réglementations influencent-elles les décisions relatives au matériel d'inférence sur site ?

L'influence de la réglementation est la façon dont les exigences de gouvernance - documentation, responsabilité, contrôle des risques et règles de traitement des données - poussent les organisations à effectuer des inférences à l'intérieur de limites contrôlées, car les pistes d'audit et la localisation des données sont plus faciles à prouver lorsque l'infrastructure est détenue et physiquement accessible plutôt que distribuée à travers des services en nuage de tiers.

Le RMF sur l'IA du NIST et la loi européenne sur l'IA sont deux signaux forts qui montrent que cette pression ne faiblit pas.

Conclusion

Si vous voulez vraiment vous lancer dans l'edge AI ou l'inférence sur site, arrêtez de choisir un châssis en dernier. Commencez par là.

Consultez des modèles de référence comme celui d'iStoneCase Options de boîtier rackable 4U et Gamme de boîtiers pour serveurs GPU 6U, puis testez vos exigences par rapport aux contraintes réelles de déploiement (poussière, temps de service, bruit et watts).

Et si votre déploiement est adjacent à une usine ou à un terrain, lisez ceci avant de monter quoi que ce soit : coffrets serveurs muraux de qualité industrielle pour les réseaux d'usine.