率直に答えてほしい: デュアルノードシャーシにGPUを搭載することは可能であるばかりでなく、実用的でもある。.1つの筐体に2つのホットスワップノードを搭載することで、密度を高め、電源とファンを共有し、運用をよりシンプルにすることができます。コツは、適切なシャーシ、冷却経路、I/Oレイアウトを選び、SKUをロックすることで、構築時に「不思議な」変更がないようにすることです。以下では、実際の制約とその見返りを、表と具体的な教訓を交えてわかりやすく説明する。また IStoneCase OEM/ODMまたはバルクが必要な場合に適合します。

デュアルノードシャーシGPUフィージビリティ(マルチGPUで2U/4U)

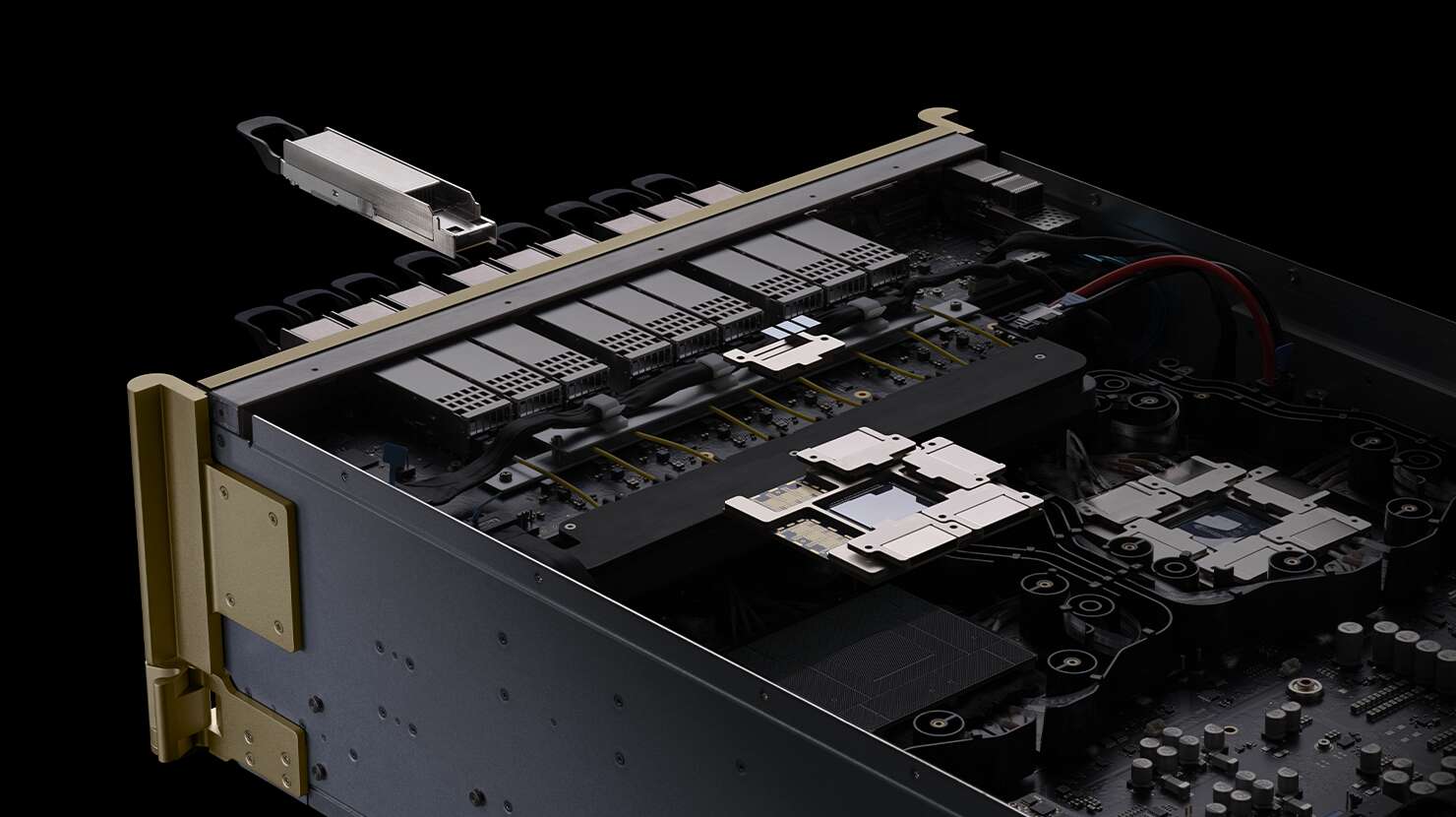

A デュアルノードシャーシ は、2つの独立したコンピュート・スレッドを備えた1つのボックスだ。各ノードには独自のCPU、メモリ、ストレージ、PCIeレーンがある。シャーシは電源とファンウォールを共有します。適切なエアフローとレーンマッピングにより、各ノードは複数のGPUを駆動することができます。多くの場合、スロットのジオメトリと熱に応じて、3つのダブルワイドまたはそれ以上のシングルワイドです。

をお探しなら サーバーラックPCケース, サーバーPCケースあるいは コンピューターケースサーバー デュアルノード+アクセラレータをホストできるGPUの場合、GPUのTDPとファンおよびPSUのヘッドルームを一致させることから始めます。推測ではなく、ファンカーブとPSUスペックを読み、余裕を持たせる。

PCIe 4.0 x16レーンとOCP 3.0 NIC(帯域幅とトポロジー)

GPUはレーンが大好き。目指せ PCIe 4.0 x16 アクセラレータあたり(またはPCIe 5.0が利用可能な場合はPCIe 5.0あたり)。使用方法 OCP 3.0 NIC (AIOM)を使用することで、余分なスロットを消費することなく100G以上のアップリンクが可能になる。次の点に注意 PCIe分岐 ボードベンダーからのルール。もし GPUDirectっぽい ノード間のパターン(例えば、シャード化されたモデルのトレーニングやヘビーなAll-to-All推論など)は、以下のようにファブリックを計画する。 インシャーシGPU-to-GPU そして クロスノード トラフィックはどちらも余裕がある。NIC1枚でボトルネックになっているピカピカのGPUファームほど痛いものはない。

2U/4Uデュアルノードサーバーの電力と冷却エンベロープ

これがビルドの成功、あるいはオーバーヒートの原因である。確認する:

- PSUヘッドルーム レールの近くを走らないこと。

- 前後気流 ホット/コールド通路に合わせる。空白のパネルを埋め、圧力漏れを残さない。

- ファン壁回転数と音響/MTBFの比較 ターゲット静圧の高いファンが味方だ。

- GPUのTDPが高い場合は、次のことを検討してください。 液体対応コールドプレート または背の高いRU。4Uの方が2Uよりもヒートシンクが大きく、ケーブルの取り回しがすっきりすることもあります。

より広いサーマルやより多くのスロットが必要な場合は、IStoneCaseのファミリーをご覧ください:

これらのカバー ATX/E-ATXレイアウト が必要なときに便利だ。 atxサーバーケース より余裕のあるオプションである。

実際のワークロードVDI、レンダリング、AI推論、メディア・トランスコード

デュアルノードGPUボックスは、"あったらいいな "という理由で買うものではない。仕事を出荷するために買うのだ:

- AI推論(バッチ&オンライン):ノードあたりのマルチGPUにより、SKUごとにモデルをピン留めし、水平方向に拡張できます。LLMサービング、ベクトル検索、コンピュータビジョンに最適です。

- レンダリングとM&E:昼間はリモートワークステーション、夜間はレンダーファーム。2つのノードにより、インタラクティブセッションとキュージョブを分けることができます。

- 仮想装置:シングルワイドGPUを搭載し、電力を消費しながらもフレームをプッシュ。

- トランスコード/ストリーミング:NVENC/NVDECの密度は、1つのシャーシに多くのシングルスロットカードを放り込んだときに輝く。

- エッジ/ブランチ:頑丈なラックは、スペアと給電が厳しいため、デュアルノードを好みます。1つのボックスで2つの独立したノードがあるため、トラックの移動が少なくて済みます。

主張-証拠-影響(表)

| 主張(何が真実か) | エビデンス/スペック(代表的なもの) | インパクト(それがどうした) | ソース・タイプ |

|---|---|---|---|

| デュアルノードの2U/4Uでは、ノードごとに複数のGPUをホスト可能 | ノード毎 PCIe 4.0 x16 スロット。 3×ダブルワイド または 4-6×シングル・ワイド レイアウトによる | 小型RUで高密度、よりシンプルな電源とファンの共有 | ベンダーのデータシートとプラットフォームのクイックスペック |

| 共有PSUとファンウォールによるオーバーヘッドの削減 | 冗長 2.x kW 一般的なPSU、静圧の高いファンウォール | 効率が向上し、在庫するFRUが減少 | ベンダーのデータシート、ラボのバーンインノート |

| OCP 3.0 NICがPCIeスロットを解放 | NICとして AIOM/OCP 3.0100/200Gオプション | より多くのGPUを搭載、すっきりしたケーブル配線、より高い東西BW | ボード・マニュアル、ビルド・ログ |

| サーマル・ゲートGPU数 | ファンウォール CFM/SP → 負荷時のGPU温度安定化 | ダウンクロック防止、部品寿命延長 | 検証のサーマルログ |

| SKUロックで不測の事態を回避 | 同じボードレブ、ライザー、シュラウド、ケーブルキット | 反復可能な製造、予測可能なリードタイム | 調達SOPおよびBOM管理 |

| デュアルパーパス・サイクルがROIを高める | 昼はワークステーション、夜はバッチジョブ | 余分なラックなしで高い稼働率 | お客様のPoC日記 |

| 4U/5U/6Uは熱のリスクを回避できる | 背の高いシャーシ=大きなヒートシンク+容易なケーブル配線 | より低いファン回転数、より低いノイズ、より少ない熱事故 | 現場展開、NOCレポート |

注:上記の値は業界の一般的な構成を反映したもので、正確な限界値は選択したボード、ライザー、クーラーによって異なる。

実際にチェックすべきノードレベルの部品表(BOM)

- CPUソケット&レーンマップ:NVMeとNICの後のPCIeレーンの合計を確認する。

- ライザーとスロット間隔:ダブルワイドGPUは2スロットの間隔が必要です。

- OCP 3.0スロット:100G以上のファブリックのために予約してください。

- ファンウォール+シュラウド:適切なエアシュラウドを使えば、GPUの温度を2桁℃下げることができる。

- PSU SKU:同じワット数、同じ効率ビン。

- ファームウェア・バンドル:BIOS/BMC/PCIeリタイマーのバージョンをロックする。混在させないでください。

これは退屈な事務作業だが、艦隊を健全に保つためのものだ。

実践的なデプロイメント・パターン(専門用語もあるが役に立つ)

- コールド・アイル/ホット・アイルの規律:フィラーの取り付け、ケーブルの切り込みにブラシストリップ、"スイスチーズ "フロントはなし。

- RU予算対熱量:ワット/GPUで2Uが厳しい場合、 4Uへのステップ そして、物理学と戦うのを止める。

- 生地レイアウトノードあたり2×100G(またはそれ以上)で分割 南北 そして 東西 トラフィック。サービス・メッシュ+ストレージ・ストリームを考えてみよう。

- MTBFとFRU在庫:予備のソリ、PSU、ポッド1つにつき少なくとも1つのライザーキットを用意すること。

- 観測可能性:BMCとGPUのテレメトリーをエクスポートし、スロットル前に忍び寄るファンの故障をキャッチします。ロケット科学ではないが、夜を節約できる。

OEM/ODMまたはバルクが必要な場合のIStoneCaseオプション

もしあなたのチームが サーバーPCケース または atxサーバーケース デュアルノードGPUビルド用に調整されている、 IStoneCase (IStoneCase -) 世界有数のGPU/サーバーケースおよびストレージシャーシOEM/ODMソリューションメーカーデータセンター、アルゴリズムハブ、企業、MSP、研究所、開発者向けのケースやカスタマイズを出荷しています。まずはこちらから:

- カタログ概要 GPUサーバーケース

- 背が高く、涼しい: 4U GPUサーバーケース - 5U GPUサーバーケース - 6U GPUサーバーケース

- ワークステーションに適したGPUケース: ISC GPUサーバーケース WS04A2 - ISC GPUサーバーケースWS06A

- エンド・ツー・エンドの仕立て: カスタマイズサーバーシャーシサービス

我々はそうする OEM/ODMバルクオーダー、スペック調整(レール、ガイドキット、ケーブルルーティング、ソリハンドル)。変わったボードや風変わりなライザーをお持ちの場合は、シートメタルやエアフローガイドを調整します。それが私たちの本業です。

ワークロードとハードウェアのクイックマッピング(表)

| ワークロード / シナリオ | ノードGPUフォームファクター | NICプラン | シャシー・ピック |

|---|---|---|---|

| スケールの大きなAI推論 | ノードあたり3×シングルワイド(または2×ダブルワイド | デュアル100G; サービスとストレージの分割 | TDPが中程度なら2Uデュアルノード。 4U GPUサーバーケース 熱い場合 |

| 昼はリモートワークステーション、夜はレンダリング | ノードあたり2-3×ダブルワイド | 100-200G、レンダーキューのQoS | 5U GPUサーバーケース より静かなファンのために |

| VDIファーム | ノードあたり4-6×シングル幅 | ノードあたり100G、ユーザーに近いL2/L3 | 6U GPUサーバーケース 涼しさが必要なら |

| エッジ/ブランチラック | ノードあたり1-2×シングル幅 | 25-100G、コンパクトな光学系 | ISC GPUサーバーケース WS04A2 |

| メディア・トランスコード | ノードあたり4×シングル・ワイド | 100G、マルチキャスト/ABR対応 | カタログ GPUサーバーケース またはカスタマイズ |